EEUU, 7 de abril 2022.-.- Google quiere facilitar la búsqueda de cosas que son difíciles de describir con solo unas pocas palabras o una imagen.

El jueves, Google lanzó una nueva opción de búsqueda que te permite combinar texto e imágenes en una sola consulta. Con esta función, puedes buscar una camisa similar a la de una foto, pero escribir que la quieres con "lunares", o tomar una foto de tu sofá y escribir "silla" para encontrar una que se parezca.

La función, que la empresa denomina "búsqueda múltiple" y que se mostró en versión preliminar en septiembre, ya está disponible para los usuarios de EE.UU. en la parte Google Lens de la aplicación móvil de Google. Liz Reid, vicepresidenta de Búsqueda de Google, le dijo a CNN Business que la función se considerará experimental al principio. Se espera que inicialmente se utilice para búsquedas relacionadas con las compras, aunque no se limita a tales consultas.

"Esto será solo el comienzo", dijo Reid.

Multisearch, que en español se traduce como multibúsqueda, marca el último esfuerzo de Google para hacer que la búsqueda sea más flexible y menos limitada a las palabras en una pantalla. Google ha ofrecido durante mucho tiempo un motor de búsqueda de imágenes. También está Google Lens, una función que se estrenó en 2017 y que puede identificar objetos en una imagen o traducir inmediatamente el texto tal como se ve a través de la lente de la cámara de un teléfono. Otro esfuerzo en 2020 les dio a los usuarios la opción de tararear una canción para buscarla.

-¿Cómo funciona el nuevo modo multisearch?-

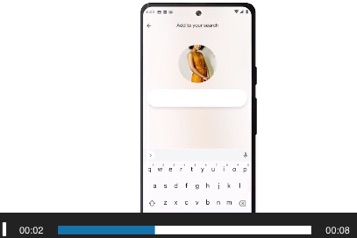

Para encontrar búsquedas múltiples en la aplicación móvil de Google, debes tocar el ícono de una cámara en el lado derecho de la barra de búsqueda, que abre Google Lens. Puedes tomar o cargar una foto y luego tocar una pequeña barra que contiene un signo de más y la frase "agregar a tu búsqueda". Esto te permite escribir palabras para explicar mejor lo que quieres.

El modo multisearch funciona esencialmente mediante el uso de inteligencia artificial de varias maneras. La visión computacional deduce lo que hay en la imagen, mientras que el procesamiento del lenguaje natural determina el significado de las palabras que escribes. Esos resultados luego se juntan para entrenar un sistema general, dijo Reid.

Cuando Google introdujo este tipo de búsqueda en septiembre, la compañía explicó que usaría una poderosa herramienta de aprendizaje automático llamada MUM (que significa "modelo unificado multitarea") que presentó en mayo pasado. Reid dijo en una entrevista la semana pasada que este no será el caso al principio, pero que puede usar MUM en los próximos meses, lo que dijo que cree que ayudará a mejorar la calidad de la búsqueda.

Cuando se le preguntó si Google finalmente hará posible que las personas usen la búsqueda de formas aún más variadas, como combinar música y palabras en una consulta para encontrar nuevos tipos de música, Reid dijo que la empresa no está trabajando en eso específicamente, pero que está interesada en combinar varias aportaciones en el futuro.